随着VR设备和内容的广泛使用,对3D场景生成技术的需求越来越普遍。然而,现有的 3D 场景生成模型将目标场景限制在特定领域,这主要是因为它们使用的 3D 扫描数据集与现实世界相去甚远。为了解决这种局限性,我们提出了LucidDreamer,这是一个无域场景生成管道,它充分利用了现有大规模基于扩散的生成模型的强大功能。

LucidDreamer项目地址:https://luciddreamer-cvlab.github.io/

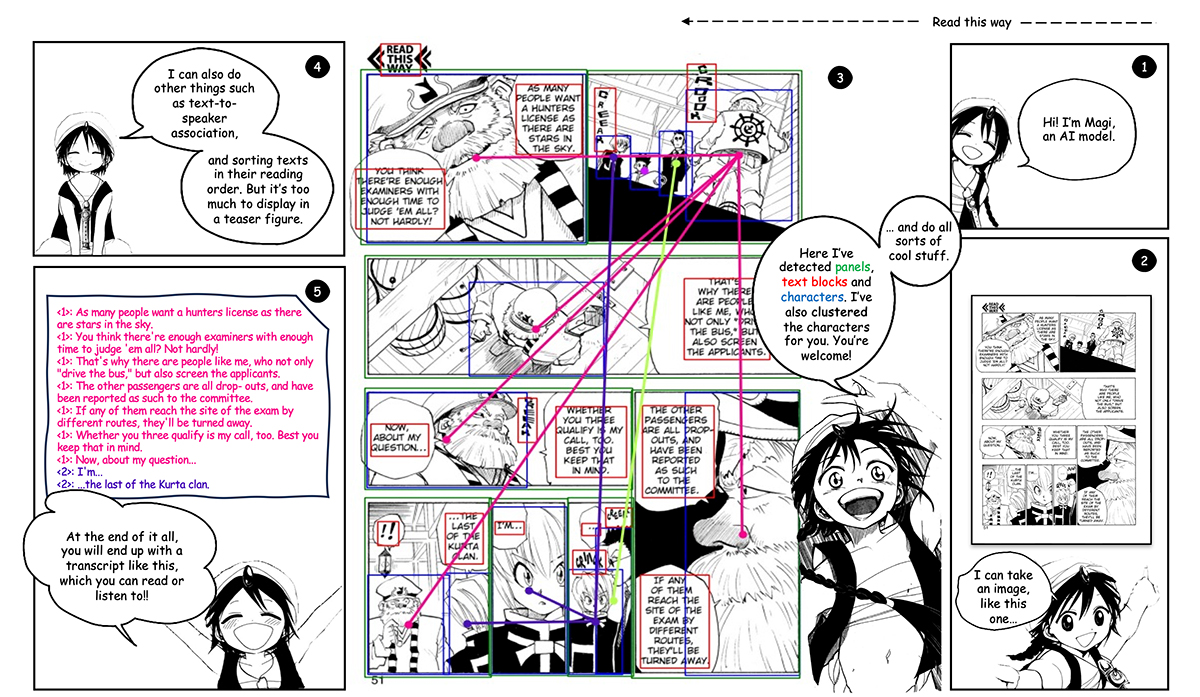

我们的 LucidDreamer 有两个交替步骤:做梦和对齐。

首先,为了从输入生成多视图一致的图像,我们将点云设置为每次生成图像的几何参考。具体来说,我们将一部分点云投影到所需的视图,并提供投影作为使用生成模型进行修复的指导。使用估计的深度图将绘制的图像提升到 3D 空间,从而组成一个新点。

其次,为了将新点聚合到3D场景中,我们提出了一种对齐算法,该算法将新生成的3D场景的各个部分和谐地集成在一起。最终得到的3D场景是优化高斯飞溅的初始点。与以前的 3D 场景生成方法相比,LucidDreamer 生成的高斯飞溅非常详细,对目标场景的域没有限制。

LucidDreamer 可以接受一系列文本提示来生成场景,从而实现细粒度的控制。

基于 CLIP 的 Stable Diffusion 生成的图像对生成的场景进行定量比较。 我们使用 CLIP-Score 和 CLIP-IQA 与 RGBD2 对结果进行定量比较。 对于 CLIP-IQA,我们使用质量、色彩鲜艳和清晰的标准。 LucidDreamer 在所有指标上都显示出占主导地位的结果。

根据初始SfM点的来源重建高斯飞溅的度量。我们使用 COLMAP并比较重建结果。使用我们的点云始终如一地显示出更好的重建指标。

数据评估

AI工具箱提供的LucidDreamer都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由AI工具箱实际控制,在2024年10月6日 上午3:21收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,AI工具箱不承担任何责任。